A gépi tanulás korszakában élünk. Az adatok mennyisége robbanásszerűen növekszik, a modellek egyre kifinomultabbak, és a valós idejű előrejelzések mindennapi termékek részévé válnak. Mindezek mögött egy kulcsfontosságú elem áll: a számítás.

Ezért egyre gyakrabban hallom a következő kérdést:

„Átállunk a CPU-król a TPU-kra? Végül a fejlesztőknek mindent TPU-khoz kell majd fejleszteniük?”

Vessünk egy pillantást a valós helyzetre – mi is valójában a CPU, a GPU és a TPU, miért hozták létre a TPU-kat, milyen széles körben használják őket ma, és mit jelent ez a szoftverfejlesztés jövője szempontjából.

1. CPU, GPU, TPU – Mi a különbség közöttük?

| CPU — Az univerzális munkás | GPU — A párhuzamos erőmű | TPU — Kifejezetten AI-hoz tervezve |

|---|---|---|

| A CPU-t úgy tervezték, hogy sokféle feladatot elvégezzen: operációs rendszerek, alkalmazások, szerverlogika, böngészők, fordítók, stb. Kiválóan alkalmas komplex vezérlési folyamatokhoz, de nem rendkívül gyors több ezer művelet egyszerre történő végrehajtásában. | Eredetileg grafikus célokra fejlesztették ki, de a GPU-k tökéletesnek bizonyultak a mélytanuláshoz, mivel a neurális hálózatok nagymértékben támaszkodnak mátrix- és vektoroperációkra. A GPU-k több ezer apró műveletet tudnak egyszerre futtatni — ideálisak a legtöbb ML-modell képzéséhez és futtatásához. | A TPU (Tensor Processing Unit) a Google saját fejlesztésű chipje, amelyet kifejezetten mélytanulási feladatokhoz terveztek. Míg a GPU sokféle nehéz számításhoz igyekszik rugalmas lenni, a TPU egyetlen célja van: a neurális hálózatokat a fizikailag lehetséges leggyorsabban és leghatékonyabban futtatni. |

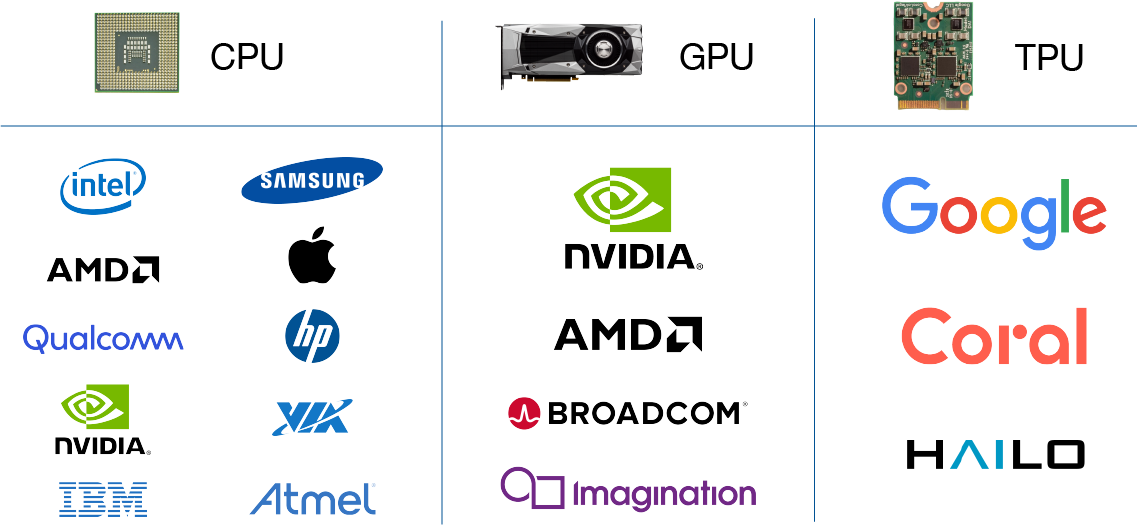

Kik gyártják a CPU-kat, GPU-kat és TPU-kat?

CPU gyártók: Intel, AMD, Qualcomm, NVIDIA, IBM, Samsung, Apple, Hewlett-Packard, VIA, Atmel stb.

GPU gyártók: NVIDIA, AMD, Broadcom Limited, Imagination Technologies (PowerVR)

TPU gyártók: Google, Coral (a Google tulajdonában), HAILO

2. Miért léteznek a TPU-k: mi a technikai előnyük?

A TPU-k a Tensor Processing Units (tenzorfeldolgozó egységek) rövidítései, amelyek alkalmazásspecifikus integrált áramkörök (ASIC-ek). A TPU-kat a Google tervezte meg a nulláról; 2015-ben kezdték el használni őket, és 2018-ban hozták nyilvánosságra. A TPU-k felhőként vagy a chip kisebb változataként érhetők el. A felhőalapú TPU-k hihetetlenül gyorsak a sűrű vektor- és mátrixszámítások végrehajtásában, hogy felgyorsítsák a neurális hálózatok gépi tanulását a TensorFlow szoftveren. A TensorFlow egy nyílt forráskódú gépi tanulási platform, amelyet a Google Brain Team fejlesztett ki, hogy segítse a fejlesztőket, kutatókat és vállalkozásokat az AI-modellek futtatásában és üzemeltetésében a Cloud TPU hardver által támogatott, magas szintű TensorFlow API-kon. A TPU-k minimalizálják a nagy és komplex neurális hálózati modellek képzésének pontosságához szükséges időt. A TPU-k segítségével a mélytanulási modellek, amelyek képzése korábban hetekig tartott a GPU-kon, most csak néhány órát vesz igénybe a TPU-kon.

TPU-k jellemzőinek összefoglalása:

- Speciális hardver mátrixfeldolgozáshoz

- Magas késleltetés (a CPU-hoz képest)

- Nagyon nagy átviteli sebesség

- Számítások extrém párhuzamossággal

- Nagy mennyiségű adatfeldolgozáshoz és CNN-ekhez (konvolúciós neurális hálózatok) optimalizált

3. Különleges kódra van szükség a TPU használatához?

Rövid válasz: nem.

A legtöbb gépi tanulási kód pontosan ugyanúgy néz ki CPU-n, GPU-n és TPU-n. A TensorFlow-ban például az egyetlen TPU-specifikus kiegészítés egy stratégia meghatározása:

resolver = tf.distribute.cluster_resolver.TPUClusterResolver()

tf.config.experimental_connect_to_cluster(resolver)

tf.tpu.experimental.initialize_tpu_system(resolver)

strategy = tf.distribute.TPUStrategy(resolver)Minden más – a modell architektúrája, a képzési ciklus, a veszteségfüggvények – változatlan maradnak.

A TPU-k nem egy új programozási univerzum. Ezek olyan nagy teljesítményű motorok, amelyeket a már megírt ML-kódodhoz csatlakoztathatsz.

4. Szóval... A TPU-k valóban népszerűek?

Itt kezdődnek a tévhitek. Sok fejlesztő alig hallott a TPU-król, ezért azt feltételezik, hogy nem használják őket széles körben. Az igazság ennél árnyaltabb.

Hol valóban népszerűek a TPU-k

- Nagy technológiai vállalatok, amelyek hatalmas nyelvi modelleket képeznek

- Google Search rangsorolási modellek

- JAX kutatók

- Nagy akadémiai laboratóriumok

- Google Cloud felhasználók, akiknek hatalmas képzési sebességre van szükségük

- Nyílt forráskódú LLM csoportok, amelyek a Google TPU Research Cloud szolgáltatását használják

Ahol nem használják széles körben

- Személyi számítógépek (kereskedelmi forgalomban nem létezik)

- Független fejlesztők

- Játékfejlesztés

- Általános szoftverfejlesztés

- Szabványos háttérmunka

Más szavakkal: A TPU-k dominálnak a nagyméretű AI-képzésben, de a mindennapi fejlesztésben nem tartoznak a mainstreamhez.

És ez teljesen rendben van – nem minden eszköznek kell minden problémát megoldania.

5. Végül a fejlesztők is „átállnak” a TPU-fejlesztésre?

Nem valószínű. A jövő hibridnek tűnik. Íme a reális kép:

- Webalkalmazások → CPU

- Játékok és grafika → GPU

- Kis/közepes ML projektek → GPU

- Óriási modellek (LLM-ek, transzformátorok) → TPU vagy GPU klaszterek

- Tudományos ML (JAX, szimulációk) → TPU egyre népszerűbb

A TPU-k nem fogják felváltani a CPU-kat vagy GPU-kat. Egyszerűen csak egy nagyon specifikus területet vesznek át: rendkívül nagy neurális hálózatok képzését.

A fejlesztők 95%-a számára a CPU-k és GPU-k továbbra is a legfontosabb eszközök maradnak.

6. A TPU-k valós felhasználási esetei (a felhajtáson túl)

Íme néhány terület, ahol a TPU-k kézzelfogható változást hoznak:

1. LLM-ek képzése

A több milliárd paraméterrel rendelkező modellek – mint például a Gemini, a PaLM és sok más új, nyílt modell – elsősorban TPU-podokon kerülnek képzésre.

2. Google Keresés

A hatalmas rangsorolási és ajánlási modellek hatékonyan épülnek fel és frissülnek a TPU-k segítségével.

3. JAX-alapú tudomány

Szimulációk, fehérjemodellezés, optimalizálási problémák – a TPU architektúra jól illeszkedik a JAX funkcionális megközelítéséhez. p>

4. Nagy volumenű videó ML

A képkockaszintű feldolgozási modellek jelentősen gyorsabban futnak a TPU hardveren. A TPU-k akkor mutatnak kiemelkedő teljesítményt, ha a munkaterhelés hatalmas és matematikailag egységes.

7. Mit kell tanulniuk a fejlesztők a jövőre nézve?

Hasznos ismeretek

- TensorFlow vagy JAX

- Modell párhuzamosság és elosztott képzés

- ML modelltervezés

- Felhőalapú számítástechnika (különösen Google Cloud)

Jó tudni, de nem elengedhetetlen

- TPU belső működése

- Alacsony szintű teljesítmény-optimalizálás TPU-khoz

Nem kell feltétlenül aggódni a következők miatt

- Speciális TPU programozási nyelvek

- Helyi TPU fejlesztés (amúgy sem elérhető)

Nem kell szakosodnod a TPU-kra, hacsak nem nagy léptékű gépi tanulással foglalkozol. De ha tudod, hogyan kell használni őket, az mindenképpen erős versenyelőnyt jelent.

Záró gondolatok

A TPU-k soha nem voltak hivatottak a CPU-k vagy GPU-k helyettesítésére. Azért hozták létre őket, mert a mélytanulás olyan gyorsan terjedt el, hogy a hagyományos hardverek nem tudták követni a fejlődést. Ma a TPU-k a világ legnagyobb mesterséges intelligencia modelljeinek nagy részét működtetik, de még mindig speciális eszközök, nem általános célú számítástechnikai eszközök.

Ha fejlesztő vagy:

- Nem kell „átállnod” a TPU-fejlesztésre.

- De ha belépsz a nagyléptékű AI világába, a TPU-k értékes részévé válnak az eszköztárodnak.

Hosszú távon az ökoszisztéma valószínűleg így fog kinézni:

CPU-k mindenhez. GPU-k sok mindenhez. TPU-k a legnagyobb feladatokhoz.